从网站抓取数据的3种最佳方法

网络爬虫:网络爬虫是一种自动化的程序,它可以按照预设的规则浏览和抓取互联网上的数据。网络爬虫的工作方式类似于搜索引擎的爬虫,遍历网页并提取所需的信息。

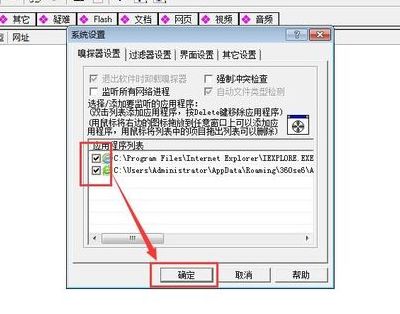

互联网采集数据有以下几种常见的方法: 手动复制粘贴:通过手动复制网页上的数据,然后粘贴到本地文件或数据库中。 编写爬虫程序:使用编程语言编写爬虫程序,模拟人类在浏览器中访问网页的行为,自动抓取网页上的数据。

数据采集的方法有多种,以下是一些常见的数据采集方法: 手动采集:通过人工浏览网页、复制粘贴等方式,将需要的数据手动提取出来。这种方法适用于数据量较小、采集频率较低的情况。

数据采集方法主要有以下几种: 网络爬虫:网络爬虫是一种自动化工具,可以自动从互联网上抓取数据。它通过模拟正常的人类用户访问网页的行为,使用各种编程语言和工具来解析网页并提取所需的数据。

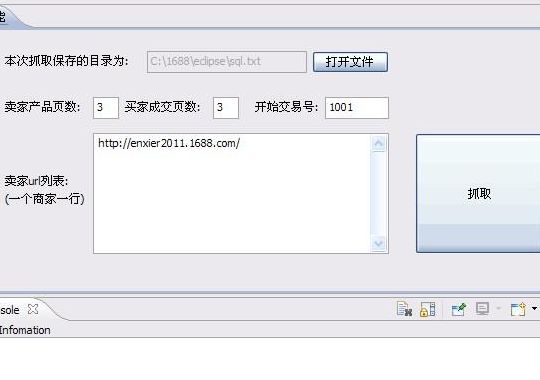

在抓取大量数据后,需要选择一个适合自己需求的存储方式。常见的存储方式有MySQL、MongoDB、Redis等。每种方式都有自己的优缺点,需要根据自己的情况进行选择。

数据采集的方法和技巧有很多种,以下是一些常用的方法和技巧: 使用网络爬虫工具:网络爬虫工具可以帮助您自动抓取网页上的数据。

网络爬虫的数据采集方法有哪些?

数据采集的方法有多种,以下是一些常见的数据采集方法: 手动采集:通过人工浏览网页、复制粘贴等方式,将需要的数据手动提取出来。这种方法适用于数据量较小、采集频率较低的情况。

互联网采集数据有以下几种常见的方法: 手动复制粘贴:通过手动复制网页上的数据,然后粘贴到本地文件或数据库中。 编写爬虫程序:使用编程语言编写爬虫程序,模拟人类在浏览器中访问网页的行为,自动抓取网页上的数据。

数据采集有多种方法,以下是其中的五种常用方法: 手动采集:通过人工浏览网页,复制粘贴所需数据的方法。这种方法适用于数据量较小或需要人工筛选的情况,但效率较低且容易出错。

从网站抓取数据有多种方法,以下是三种最佳方法: 使用API接口:许多网站提供API接口,允许开发者通过API获取网站上的数据。使用API接口可以直接从网站的数据库中获取数据,速度快且准确。

如何爬虫网页数据

1、以下是使用Python编写爬虫获取网页数据的一般步骤: 安装Python和所需的第三方库。可以使用pip命令来安装第三方库,如pip install beautifulsoup4。 导入所需的库。例如,使用import语句导入BeautifulSoup库。

2、基于API接口的数据采集:许多网站提供API接口来提供数据访问服务,网络爬虫可以通过调用API接口获取数据。与直接采集Web页面相比,通过API接口获取数据更为高效和稳定。

3、安装必要的库 为了编写爬虫,你需要安装一些Python库,例如requests、BeautifulSoup和lxml等。你可以使用pip install命令来安装这些库。抓取网页数据 主要通过requests库发送HTTP请求,获取网页响应的HTML内容。

4、以下是网络爬虫的入门步骤: 确定采集目标:首先需要明确你想要采集的数据是什么,以及数据来源是哪个网站或网页。 学习HTML和XPath:了解HTML和XPath的基本知识,这是进行网页解析和数据提取的基础。

5、拿爬取网站数据分析:用浏览器开发者工具的Network功能分析对应的数据接口或者查看源代码写出相应的正则表达式去匹配相关数据 将步骤一分析出来的结果或者正则用脚本语言模拟请求,提取关键数据。

6、首先要明确想要爬取的目标。对于网页源信息的爬取首先要获取url,然后定位的目标内容。先使用基础for循环生成的url信息。然后需要模拟浏览器的请求(使用request.get(url)),获取目标网页的源代码信息(req.text)。

wireshark抓取网页使用什么命令?

1、运行wireshark软件,选择无线网络连接,点击start,进入捕包界面,在filter(过滤器)的方框中,输入http。 点击右侧的apply(应用),就能捕获指定的网站数据包。

2、在电脑中,打开wireshark软件。点击抓取网络接口卡选择按钮,选择需要抓取的网卡接口。如果不确定是那个网络接口,则可以看packes项数据变化最多接口,选中它然后点击"start开始抓包。

3、在如下链接下载“Wireshark”并在电脑上安装。Wireshark下载地址 (若链接失效,请在此页面下载:http://)如果之前没有安装过“Winpcap”请在下面图上把安装“Winpcap”的勾选上。

4、用wireshark只能捕获到程序安装所在计算机上的数据包,dns解析是一个涉及不同域名服务器的过程,你无法在本机上得知全部过程,但是能捕获到解析请求和最终的返回结果。首先打开wireshak,开始捕捉。

如何抓取网页上的数据(如何使用Python进行网页数据抓取)

1、首先要明确想要爬取的目标。对于网页源信息的爬取首先要获取url,然后定位的目标内容。先使用基础for循环生成的url信息。然后需要模拟浏览器的请求(使用request.get(url)),获取目标网页的源代码信息(req.text)。

2、以下是使用Python编写爬虫获取网页数据的一般步骤: 安装Python和所需的第三方库。可以使用pip命令来安装第三方库,如pip install beautifulsoup4。 导入所需的库。例如,使用import语句导入BeautifulSoup库。

3、通过编写Python程序,可以模拟人类在浏览器中访问网页的行为,自动抓取网页上的数据。Python网络爬虫可以通过发送HTTP请求获取网页内容,然后使用解析库对网页进行解析,提取所需的数据。

文章声明:以上内容(如有图片或视频亦包括在内)除非注明,否则均为网友提供,转载或复制请以超链接形式并注明出处。