如何通过网络爬虫获取网站数据?

以下是使用Python编写爬虫获取网页数据的一般步骤: 安装Python和所需的第三方库。可以使用pip命令来安装第三方库,如pip install beautifulsoup4。 导入所需的库。例如,使用import语句导入BeautifulSoup库。

首先爬虫分为爬取移动APP数据和网站数据,主要方法都是一致,但细节上有点区别。

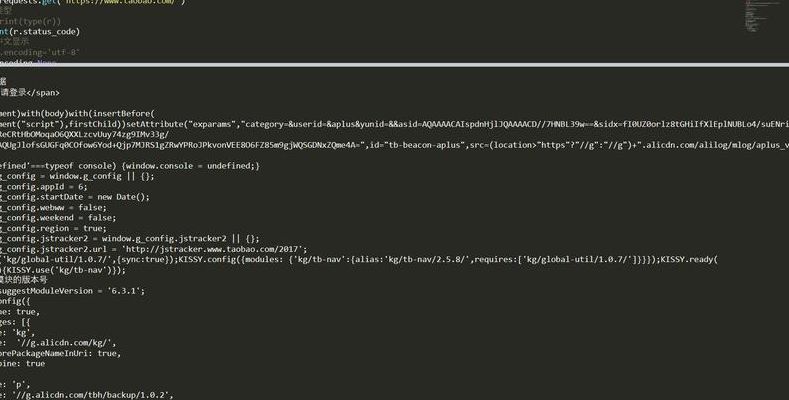

在上一篇给大家介绍的是爬虫基本流程Request和Response的介绍,本篇给大家带来的是爬虫可以获取什么样的数据和它的具体解析方式。

我们知道网页之间是通过超链接互相连接在一起的,通过链接我们可以访问整个网络。所以我们可以从每个页面提取出包含指向其它网页的链接,然后重复的对新链接进行抓取。通过以上几步我们就可以写出一个最原始的爬虫。

PHP的cURL库简单和有效地抓网页

1、使用file_get_contents获得网页源代码。这个方法最常用,只需要两行代码即可,非常简单方便。使用fopen获得网页源代码。这个方法用的人也不少,不过代码有点多。使用curl获得网页源代码。

2、简单的收集下PHP下获取网页内容的几种方法:用file_get_contents,以get方式获取内容。用fopen打开url,以get方式获取内容。使用curl库,使用curl库之前,可能需要查看一下php.ini是否已经打开了curl扩展。

3、好在互联网是 资源共享的,我们可以利用程序 自动的把别的站点的页面抓取回来经过处理后被我们所利用。 用什么呢,那个战友给的是不行的,其实在Php有这个功能,那就是用curl库。

4、刚吃完午饭吧,来帮你实现一下吧。记得加分哦。

搜索引擎蜘蛛是如何抓取网页内容的?

1、抓取 搜索引擎为想要抓取互联网站的页面,不可能手动去完成,那么百度,google的工程师就编写了一个程序,他们给这个自动抓取的程序起了一个名字,蜘蛛(也可以叫做“机器人”或者“网络爬虫”)。

2、高质量的内容 高质量的内容对于网站优化有着重要作用,高质量内容不仅仅是针对搜索引擎,同时也是针对用户。

3、蜘蛛的抓取一般喜欢以下几种行为:蜘蛛喜欢的行为一:网站和页面的权重尽可能的高,蜘蛛抓取的过程中首先考虑这种网站,因为在蜘蛛看来,质量高、建站时间长的网站才会有比较高的权重。高权重的网站甚至可以达到秒收录的效果。

4、初级蜘蛛就简单了,它一般情况只去爬行新站,爬行深度也很低,它抓取到网页的内容后,会一级一级的提交到搜索引擎数据库,然后先把数据存放起来,再过几天再来爬行,直到搜索引擎觉得爬行到的内容是有价值的才会被放出来。

5、第一步:爬行,搜索引擎是通过一种特定规律的软件跟踪网页的链接,从一个链接爬到另外一个链 接,所以称为爬行。第二步:抓取存储,搜索引擎是通过蜘蛛跟踪链接爬行到网页,并将爬行的数据存入原始页面数据库。

excel自动抓取网页数据

点击打开浏览器,把需要提取数据的网址复制下来。

首先打开一个excel表格,并选中数据菜单栏。数据菜单栏下,最左侧就是获取外部数据选项卡。选择其中的自网站外部数据来源。

首先,我们找到一个带表格的网页来演示,然后点击复制网址。然后,我们打开Excel,点击菜单栏“数据”选项卡,点击功能区“自网站”。在地址栏点击右键,把我们复制的网址粘贴到地址栏中,点击“转到”。

将网页中展示的数据爬取到可以编辑的文本工具中从而实现批量操作。在具体的爬取过程中,经常使用的根据有Excel和Python。该板块由三个模块组成:在爬虫过程中,最为常用的浏览器为谷歌浏览器和火狐浏览器。

通过编写程序,网络爬虫可以模拟人类在浏览器中访问网页的行为,自动抓取网页上的数据。Python是一种常用的编程语言,也可以用于编写网络爬虫程序。使用Python编写的爬虫程序可以帮助用户快速抓取互联网上的各种数据。

我们除了可以从本地机器上获取数据外,还可以从网络上导入数据到Excel中,并能同网络保持随时更新。

网页抓取策略有哪些

1、大站优先策略 对于待抓取URL队列中的所有网页,根据所属的网站进行分类。

2、深度优先遍历策略 深度优先遍历策略很好理解,这跟我们有向图中的深度优先遍历是一样的,因为网络本身就是一种图模型嘛。

3、逻辑上全站爬行 网站结构优化 网站物理结构,即基于内容聚合的目录及文件位置决定的结构。目前的主流思维就是网站扁平化设计,即平行结构。

4、深度优先(策略):一直往前爬,直到没有链接,再返回第一层爬向下一个入口 广度优先(策略):先把这一层所有入口爬完,再爬下一层。

5、种子URL库:URL用于定位互联网中的各类资源,如最常见的网页链接,还有常见的文件资源、流媒体资源等。种子URL库作为网络爬虫的入口,标识出爬虫应该从何处开始运行,指明了数据来源。

6、它为搜索引擎从万维网上下载网页,是搜索引擎的重要组成。传统爬虫从一个或若干初始网页的URL开始,获得初始网页上的URL,在抓取网页的过程中,不断从当前页面上抽取新的URL放入队列,直到满足系统的一定停止条件。

除了网络爬虫,还有哪些方法可以采集数据?

1、传感器采集:通过温湿度传感器、气体传感器、视频传感器等外部硬件设备与系统进行通信,将传感器监测到的数据传至系统中进行采集使用。爬虫采集:可以通过编写网络爬虫,设置好数据源后进行有目标性的爬取数据。

2、数据采集有多种方法,以下是其中五种常用的方法: 手动采集:通过人工浏览网页,复制粘贴所需数据到本地文件或数据库中。这种方法适用于数据量较小或需要人工筛选的情况。

3、数据采集的途径有多种,包括但不限于以下几种: 手动采集:通过人工浏览网页、复制粘贴等方式手动获取数据。 网络爬虫:使用编写的程序模拟人类在浏览器中访问网页的行为,自动抓取网页上的数据。

4、数据采集的基本方法有调查问卷、实地观察、采访、文献研究、实验设计、网络爬虫等等。调查问卷 通过设计并分发调查问卷,收集人们对特定主题或问题的观点、意见和反馈。实地观察 直接观察和记录事件、行为、现象等。

文章声明:以上内容(如有图片或视频亦包括在内)除非注明,否则均为网友提供或互联网,转载或复制请以超链接形式并注明出处。